能让模型推理能力无上限?田渊栋下场反对:两层还能模拟全世界呢

机器之心报道

机器之心编辑部

「这相当于在理论上,两层神经网络在理论上可以拟合任何数据,我们就盲目相信并应用在所有场景中。」

大模型新范式OpenAIo1一经发布,如何「复刻」出o1便成为了AI圈最热的话题。

由于OpenAI对技术细节守口如瓶,想从AI那里「套话」,让它复述完整的内部推理过程,多问几句,OpenAI直接发邮件警告要撤销你的使用资格。想从技术报告中想找出点蛛丝马迹,也同样困难。于是,能让模型推理能力无上限?田渊栋下场反对:两层还能模拟全世界呢大家将目光转向了以往类似的研究成果,希望从中找到些线索。

比如,GoogleBrain推理团队创建者DennyZhou立刻拿出了他在今年5月份发表的论文:《ChainofThoughtEmpowersTransformerstoSolveInherentlySerialProblems》。这篇论文的作者阵容也很豪华,除了DennyZhou,还有斯隆奖得主马腾宇以及他的两位学生。

DennyZhou表示,他们已经在数学上证明,只要允许Transformer模型生成足够多的中间推理tokens,它们就能解决任何问题,让LLM的推理没有上限。

概括起来,这篇论文主要证明了引入思维链(CoT)能够显著提升Transformer的表达能力,使其能处理更加复杂的问题。

加入CoT

1层的Transformer也能做复杂推理题

一直以来,大家都在寻找突破Transformer架构的方法。Transformer虽擅长并行计算,却难以处理串行推理。并行计算意味着模型可以同时处理多个步骤,对于需要逐步推理的问题尤为重要。

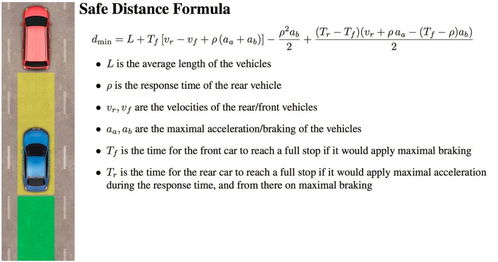

对此,论文作者们提出了一个假设:CoT可以帮助Transformer完成原本无法做到的串行计算。

论文作者们采用了电路复杂性(circuitcomplexity)来讨论Transformer的能力。

电路复杂性按复杂程度分为不同类别,如:

此前的研究已经表明,仅解码器架构的Transformer能够高效并行计算,但它们的计算能力有限,只能解决通过TC⁰类电路能够计算的问题。如果限制条件更加严格,不允许使用多数决定门时,Transformer的计算能力只能解决AC⁰类问题。

论文指出,没有CoT时,Transformer的串行计算次数受到模型深度的限制,深度越大,能处理的串行计算步数越多。但深度是固定的,无法随任务增加而增长。引入CoT,则解决了这个问题,能让Transformer生成T步的中间步骤,增加串行计算的次数到T。

论文进一步证明,如果Transformer的嵌入维度与输入序列长度的对数成比例,并且配备T步的中间步骤,那么该Transformer能够模拟大小为T的布尔电路,进而解决P/poly类问题。如果T值线性增长,Transformer可以处理所有正规语言的问题,包括S₅这样的复杂群组合问题

为了验证上述理论分析,作者通过实验比较了引入CoT前后,Transformer在解决模加法、排列组合、迭代平方和电路值问题这四个核心任务上的表现。实验分别在三种设置下进行:

模加法(ModularAddition)

如下图所示,当p=7时,浅层Transformer在有提示的情况下能够很好地解决输入序列较短时的问题,但使用CoT时,尤其是在较长的输入序列中,模型的表现要好得多。

排列组合(PermutationComposition)

对于CoT模式,Transformer不直接计算最终结果,而是逐步地、部分地进行计算。

下图展示了排列组合(S₅)在Hint模式和CoT模式两种不同模式下的表现,其中横轴表示输入序列的长度,纵轴表示模型的层数,颜色代表准确率。

在Hint模式下,即使Transformer有12层,准确率仍然非常低,基本维持在20%左右,几乎是在1-5之间随机猜测的水平。只有当输入序列长度非常短(长度为3)且层数较多时,准确率才能有所提高,但仍然不超过56%。

在CoT模式下,Transformer表现显著提高。无论序列长度多长,准确率都接近100%。当序列长度增加至33和36时,层数为1的模型准确率有所下降,分别为54%和46%,但这仍然远高于Hint模式的表现。

迭代平方(IteratedSquaring)

如下图所示,随着模型层数和输入长度的增加,Hint模式下,Transformer的表现逐渐变差。对于较短的输入长度(如6和14),即使层数较少,Transformer仍然能保持相对较高的准确率(分别为94%和89%),但当输入长度增加到30或更长时,准确率显著下降,尤其是模型层数较少时。

而在CoT模式下,无论序列长度和模型层数如何,Transformer的表现都保持了100%的准确率。

电路值问题(CircuitValueProblem)

要计算电路值问题,模型需要根据输入:

,计算出电路最后的逻辑门m的值。

如下图所示,在Hint模式下,在序列长度较短时,准确率还能保持100%,但当长度较长时,准确率有大幅下降。使用CoT后,即使Transformer只有1层,就能达到接近100%的准确率。

更多研究细节,请参考原论文。

理论很丰满,现实却很骨感?

CoT对Transformer的增益如此强大,这令人不禁联想:o1思考时间的时间越长,准确率也会提升,或许这个思路正与o1的核心理念不谋而合?

看到能为更强大的LLM推理新范式的曙光初现,评论区一片沸腾,纷纷送上祝贺:如果这项研究是真的,那么AGI可能很近了……

与此同时,这篇论文也引发了不少争议。

比如有网友提出质疑,「所有问题都解决了,那大模型会出幻觉的问题解决了吗?」

网友进一步发难:「这种方法能算是真正基于意义的推理吗?因为它没有考虑中间层也可能会产生幻觉的问题。这感觉更像是从一堆解决方案叠加在一起,然后挑出重合的部分?不就是单纯增加了正确的概率而已?」

此外,这发生在检索阶段,而非在训练阶段,也就是说模型还是不能实时学习,无法随着输入更多数据不断改进......

还有网友指出,虽然论文中通过「模拟门电路运算」等实验从理论上进行了证明,但这样的模拟方式可能不能完全反映出大模型在真实环境中的行为。

比如对量子模拟、医学诊断等领域可能就没什么说服力。

更令人担忧的是,这种方法在现实中很难实现,因为它需要极大的计算资源和时间,而这些都会随着输入规模呈指数级增长。

「要达到人类级别的智能,暴力解法可能需要为每个问题生成上亿种解决方案。这就是为什么单靠扩展计算能力行不通。人类解决问题时不会考虑成千上万种可能性,而是凭直觉和推理迅速缩小到几个可行的选项。如果我们想实现AGI,AI系统也需要模仿这种高效的方式。」

按这个思路想下去,不少网友缓缓地打出了一个问号:这不就是智能时代的「无限猴子定理」吗?让一只猴子在打字机上随机地按键,只要给它的时间够多,它最终必然能打出任何给定的文字,无论是《红楼梦》还是《莎士比亚全集》。

HackerNews甚至就这点讨论出了一座高楼,但大多数人还是觉得,既然ICLR2024都接收了这篇论文,那应该没有问题吧?

随着论文热度的不断攀升,田渊栋和LeCun等业内大佬也亲自下场发问:「CoT,真的有这么神奇吗?」

田渊栋指出,DennyZhou等人提出了一种理论上的假设,实际操作中可能远没有那么简单。

尽管CoT非常有用,但我并不完全同意仅靠盲目扩展它就能解决所有问题。论文中提出了一种通用理论——我们可以显式地构建Transformer的权重,使其更好地适应特定任务。虽然模型的深度可以保持常数,但CoT的长度可能会非常长,而这种权重能否通过梯度下降算法学到,仍是未知数。

他用了一个形象的比喻来说明这个问题:这有点像「在理论上,两层神经网络在理论上可以拟合任何数据,我们就盲目相信并应用在所有场景中」

。

相比之下,人类的推理链非常简洁,即使面对从未见过的问题,也能迅速抓住解决问题的关键。田渊栋认为,如何学习或构建出这样的表示,是一个令人着迷的课题。

看到学生的评论,YannLeCun也发来了声援:「我本来想说这个的,但被渊栋抢先了。」

作为「深度学习三巨头」之一,LeCun表示:「两层网络和核机器(kernelmachines)可以无限逼近任何函数,因此我们不需要深度学习。你可能不敢相信,从1995年到2020年,我听过多少次这种论点!」

LeCun进一步解释道:「理论上是可行的,但问题在于,实际应用中,如果只使用两层网络,第一层的神经元数量可能会多到不可操作。」

针对「两层MLP」这个比喻中的问题,专注于生物学领域的AI研究实验室EvolutionaryScale的联合创始人ZemingLin提出了自己的想法:

「我认为我们需要为机器学习模型构建类似乔姆斯基层次结构的框架。比如,是否存在适用于机器学习模型的NP、P、O(n^2)等概念,并明确Transformer或Mamba在这个层次结构中属于哪一类。」

田渊栋表示支持:「因为涉及不同的数据分布、模型架构、学习算法、后处理等等,问题远比想象的要复杂得多。」

虽然田渊栋可能并不完全认同这篇论文的思路,但他并没有否定继续尝试的必要性。

而这篇可能证明了CoT能赋予基于Transformer架构的LLM更强推理能力的论文却让一向「不太喜欢」AGI,多次称LLM无法实现AGI的LeCun遭到了更尖锐的质疑:

我还记得你曾说过,LLM(GPT)不是AI,也永远无法达到AGI,因为它无法进行推理。

然而,现在通过CoT RL,它可以推理了。这篇论文只是证明了其他人一直以来所做的是正确的,一如既往。

为什么Meta反对通往AGI的主流路径?难道只是因为你个人不喜欢Google和OpenAI吗?

也许正如这位网友所说,「似乎有人已经知道如何拓展CoT了。OpenAI看起来对此非常有信心。」

至于这场争论的焦点:CoT是否真的能让Transformer解决所有问题,显然还需要更多研究来验证。

在最终结论揭晓前,你怎么看呢?