!推核芯片:对标英伟达

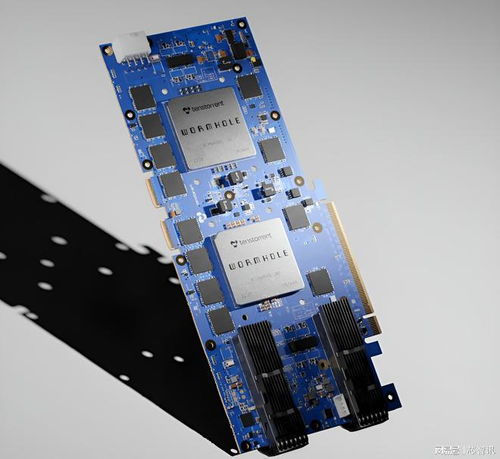

8月28日消息,由传奇芯片架构师JimKeller领导的AI芯片新创公司Tenstorrent在近日的HotChips2024活动上详细介绍了其新一代基于RISC-V架构的BlackHole系列AI处理器,性能高达745TOPS,尽管芯片集成的内存容量和带宽低于英伟达A100,但是整体的AI性能和可扩展性更优。

据介绍,这款BlackholeAI芯片共拥有768个RISC-V内核,包括16个BigRISC-V内核、752个BabyRISC-V内核,其中大量的BabyRISC-V内核被分别集成在140个Tensix人工智能计算核心当中,241MB的片上SRAM内存和一系列高速连接,可以提供745TFLOPS的FP8性能(FP16时为372TFLOPS)。Blackhole还支持32GB的GDDR6内存和基于以太网的互连,能够在其10个400Gbps链路上实现1TBps的总带宽。

BigRISC-V和BabyRISC-V

具体来说,与之前推出的基于PCIe的Greyskull和Wormhole加速芯片不同,Blackhole是一款独立的AI计算机系统。

根据TenstorrentML框架和编程模型高级研究员JasminaVasiljevic的说法,这主要归功于其内部集成的16个具有64位、双发射、顺序执行的BigRISC-VCPU内核,这些内核排列在四个集群中。至关重要的是,这些BigRISC-VCPU内核足够强大,可以用作运行Linux的设备端主机。并且,还有与之配对的752个“BabyRISC-V”内核,这些内核负责内存管理、片外通信和数据处理。

△Blackhole加速器包含16个BigRISC-V和752个BabyRISC-V内核。

然而,Blackhole实际的AI计算则主要由Tenstorrent自研的140个TensixAI内核处理,每个内核由五个“BabyRISC-V”内核、一对路由器、一个计算综合体和一些L1缓存组成。

这个计算综合体则是由一个旨在加速矩阵工作负载的平铺数学引擎和一个矢量数学引擎组成。前者将支持Int8、TF32、BF/FP16、FP8以及2bit到8bit的浮点数据类型,而矢量引擎则主要面向FP32、INT16和INT32数据类型。

根据Tenstorrent的AI软件和架构高级研究员DavorCapalija的说法,这种配置意味着该芯片可以支持AI和HPC应用中的各种常见数据模式,包括矩阵乘法、卷积和分片数据布局。

△Blackhole的BabyRISC-V核心可以进行编程以支持各种数据移动模式

总的来说,Blackhole的Tensix内核占了总共752个BabyRISC-V内核中的700个。如上图,其余的BabyRISC-V内核则负责内存管理(“D”代表DRAM)、片外通信(“E”代表以太网)、系统管理(“A”)和PCIe(“P”)。

BlackholeGalaxy系统

然而,就像英伟达的AI加速芯片通常被组成集群来使用一样,Tenstorrent的Blackhole也被设计为作为支持横向扩展系统的一部分进行部署。Tenstorrent计划将32个Blackhole加速器塞进一个4x8网格网络中,并将其称为BlackholeGalaxy系统。

△Tenstorrent的BlackholeGalaxy系统将32个Blackhole加速器组成了一个集群,可以实现近24petaFLOPS的FP8性能。

总的来说,单个BlackholeGalaxy承诺可以带来FP8的23.8petaFLOPS或FP16的11.9petaFLOPS算力,以及1TB的内存,能够实现16TBps的原始带宽。

更重要的是,Tenstorrent表示,该芯片的内核密集架构意味着这些系统中的每一个都可以用作计算或内存节点或11.2TBps高带宽的AI交换机。

“你可以把它当作乐高积木来制作一个完整的训练集群,”DavorCapalija说。

Tenstorrent认为,整个训练集群可以只使用BlackholeGalaxy系统作为“乐高积木”来构建。

相比之下,英伟达最密集的HGX/DGXA100服务器系统基本都是8个GPU组成一个系统,其FP16性能不到2.5petaFLOPS,相比之下BlackholeGalaxy的速度提高了近4.8倍。事实上,在系统级别,BlackholeGalaxy应该可以与英伟达的HGX/DGXH100和H200系统竞争,后者在FP8数据类型下,可以提供大约15.8petaFLOPS的算力。

Tenstorrent使用板载以太网来进行连接,!推核芯片:对标英伟达意味着它避免了与处理芯片到芯片和节点到节点网络的多种互连技术相关的挑战,就像英伟达使用NVLink和InfiniBand/以太网一样。在这方面,Tenstorrent的横向扩展策略与英特尔的Gaudi系列AI加速器平台非常相似,后者也使用以太网作为其主要互连。

构建软件生态系统

除了芯片之外,Tenstorrent还披露了其加速器的TT-Metalium低级编程模型。

熟悉英伟达CUDA平台的人都知道,即使竞品的硬件性能表现比英伟达更高,配套的软件也仍可以决定其成败。Capalija解释说,事实上,TT-Metalium有点让人想起CUDA或OpenCL等GPU编程模型,因为它是异构的,但不同之处在于它是从“为AI和横向扩展”计算而构建的。

这些差异之一是内核本身是带有API的普通C 。“我们认为不需要特殊的内核语言,”他解释说。

Tenstorrent旨在支持许多标准模型运行时,如TensorFlow、PyTorch、ONNX、Jax和vLLM。结合包括TT-NN、TT-MLIR和TT-Forge在内的其他软件库,Tenstorrent旨在支持使用PyTorch、ONNX、JAX、TensorFlow和vLLM等常用运行时在其加速器上运行任何AI模型。

对这些高级编程模型的支持应该有助于抽象出跨这些加速器部署工作负载的复杂性,类似于我们在AMD和Intel加速器中看到的情况。

编辑:芯智讯-浪客剑编译自:theregister